(Berechnung) Markierung: Visuelle Bearbeitung |

Keine Bearbeitungszusammenfassung Markierung: Visuelle Bearbeitung |

||

| Zeile 12: | Zeile 12: | ||

== Berechnung == |

== Berechnung == |

||

| + | <nowiki>Fisher führte kein neues Symbol ein, sondern benutzte lediglich <math>\sigma^2</math> zur Notation der Varianz. In den folgenden Jahren entwickelte er ein genetisches Modell, das zeigt, dass eine kontinuierliche [[Phänotypische Variation|Variation zwischen phänotypischen Merkmalen]], die von [[Biostatistik]]ern gemessen wurde, durch die kombinierte Wirkung vieler diskreter Gene erzeugt werden kann und somit das Ergebnis einer [[Mendelsche Regeln|mendelschen Vererbung]] ist. Auf diesen Resultaten aufbauend formulierte Fisher dann sein [[Fishers Fundamentales Theorem der natürlichen Selektion|fundamentales Theorem der natürlichen Selektion]], welches die Gesetzmäßigkeiten der Populationsgenetik für die Zunahme der Fitness von Organismen beschreibt. Zusammen mit Pearson entwickelte er u.&nbsp;a. die Grundlagen der Versuchsplanung (1935 erschien ''The Design of Experiments'') und der [[Varianzanalyse]]. Des Weiteren lässt sich die Mehrzahl der biometrischen Methoden auf Pearson und Fisher zurückführen auf deren Grundlage [[Jerzy Neyman]] und [[Egon Pearson]] in den 30er Jahren die allgemeine [[Testtheorie (Statistik)|Testtheorie]] entwickelten.<ref>Lothar Sachs: ''Statistische Auswertungsmethoden.'' 1968,1. Auflage, S. 436.</ref></nowiki> |

||

| − | In order to describe operations with dual quaternions, it is helpful to first consider quaternions.<sup>[11]</sup> |

||

| − | |||

| − | A quaternion is a linear combination of the basis elements 1, ''i'', ''j'', and ''k''. Hamilton's product rule for ''i'', ''j'', and ''k'' is often written as |

||

| − | : |

||

| − | Compute ''i'' ( ''i j k'' ) = −''j k'' = −''i'', to obtain ''j k'' = ''i'', and ( ''i j k'' ) ''k'' = −''i j'' = −''k'' or ''i j'' = ''k''. Now because ''j'' ( ''j k'' ) = ''j i'' = −''k'', we see that this product yields ''i j'' = −''j i'', which links quaternions to the properties of determinants. |

||

| − | |||

| − | A convenient way to work with the quaternion product is to write a quaternion as the sum of a scalar and a vector, that is ''A'' = ''a''<sub>0</sub> + '''A''', where ''a''<sub>0</sub> is a real number and '''A''' = ''A''<sub>1</sub> ''i'' + ''A''<sub>2</sub> ''j'' + ''A''<sub>3</sub> ''k'' is a three dimensional vector. The vector dot and cross operations can now be used to define the quaternion product of ''A'' = ''a''<sub>0</sub> + '''A''' and ''C'' = ''c''<sub>0</sub> + '''C''' as |

||

| − | : |

||

| − | A dual quaternion is usually described as a quaternion with dual numbers as coefficients. A dual number is an ordered pair ''â'' = ( ''a'', ''b'' ). Two dual numbers add componentwise and multiply by the rule ''â ĉ'' = ( ''a'', ''b'' ) ( ''c'', ''d'' ) = (''a c'', ''a d'' + ''b c''). Dual numbers are often written in the form ''â'' = ''a'' + ε''b'', where ε is the dual unit that commutes with ''i'', ''j'', ''k'' and has the property ε<sup>2</sup> = 0. |

||

| − | |||

| − | The result is that a dual quaternion is the ordered pair of quaternions ''Â'' = ( ''A'', ''B'' ). Two dual quaternions add componentwise and multiply by the rule, |

||

| − | : |

||

| − | It is convenient to write a dual quaternion as the sum of a dual scalar and a dual vector, ''Â'' = ''â''<sub>0</sub> + ''A'', where ''â''<sub>0</sub> = ( ''a'', ''b'' ) and ''A'' = ( '''A''', '''B''' ) is the dual vector that defines a screw. This notation allows us to write the product of two dual quaternions. |

||

== Herstellung von Orangensaft == |

== Herstellung von Orangensaft == |

||

Version vom 4. Juli 2019, 11:50 Uhr

Niemand hat die Absicht seriöse Quellen zu verwenden! ;)

#Definition of Doom

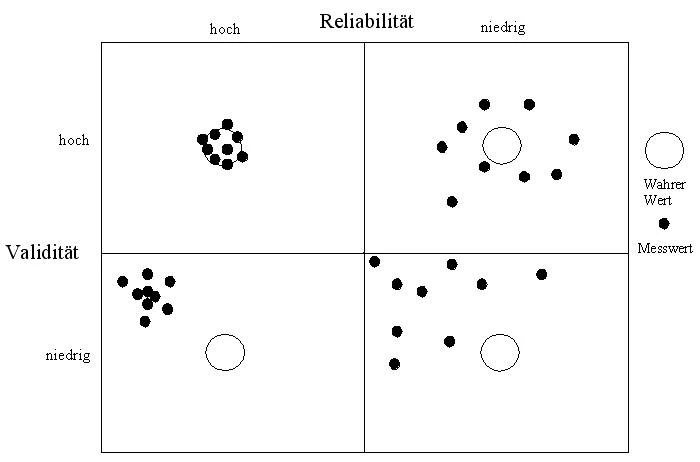

Unter Reliabilität wird der Grad der Zuverlässigkeit verstanden, mit der ein bestimmtes Merkmal gemessen wird, bzw. der Grad der Unabhängigkeit eines Ergebnisses von einem einzelnen Messvorgang. Eine Messung ist dann als reliabel zu bezeichnen, wenn die Ergebnisse bei wiederholten Messungen des gleichen Merkmals konstant bleiben, vorausgesetzt die reale Merkmalsausprägung bleibt ebenfalls unverändert. Zur Prüfung der Reliabilität von Messungen sind Retests, Paralleltests oder Tests im Split-Half-Design üblich.

Bei einem Retest werden die gleichen Merkmale an der gleichen Stichprobe mit dem gleichen Messinstrument zu zwei verschiedenen Zeitpunkten erhoben. Anhand der Korrelation der Werte lässt sich feststellen, wie stabil das Merkmal gemessen wurde. Retests sind nur dann durchführbar, wenn von einer Stabilität des Merkmals über den gesamten Testzeitraum ausgegangen werden kann. Veränderungen bei der Durchführung der zweiten Messung, beispielsweise in Ort oder Tageszeitpunkt, gefährden die Aussagekraft eines Retests.

Bei einem Paralleltest wird das gleiche Merkmal an der gleichen Stichprobe mit zwei vergleichbaren Messinstrumenten zum gleichen Zeitpunkt erhoben. Auch bei diesem Test gibt die Korrelation der Werte Auskunft darüber, wie reliabel das Merkmal gemessen werden konnte. Voraussetzung hierfür ist, dass die beiden Messinstrumente als streng vergleichbar gelten können, so dass sich eine niedrige Korrelation nicht auf etwaige Instrumenteneffekte zurückführen lässt.

Die dritte gängige Methode zur Überprüfung der Reliabilität sind Tests im Split-Half-Design. Dabei werden die Merkmale nur zu einem Zeitpunkt und mit einem Messinstrument erhoben. Das Instrument wird anschließend in zwei strukturidentische Hälften zerlegt, die daraufhin geprüft werden, ob sie gleiche bzw. ähnliche Ergebnisse zeigen.

Berechnung

Fisher führte kein neues Symbol ein, sondern benutzte lediglich <math>\sigma^2</math> zur Notation der Varianz. In den folgenden Jahren entwickelte er ein genetisches Modell, das zeigt, dass eine kontinuierliche [[Phänotypische Variation|Variation zwischen phänotypischen Merkmalen]], die von [[Biostatistik]]ern gemessen wurde, durch die kombinierte Wirkung vieler diskreter Gene erzeugt werden kann und somit das Ergebnis einer [[Mendelsche Regeln|mendelschen Vererbung]] ist. Auf diesen Resultaten aufbauend formulierte Fisher dann sein [[Fishers Fundamentales Theorem der natürlichen Selektion|fundamentales Theorem der natürlichen Selektion]], welches die Gesetzmäßigkeiten der Populationsgenetik für die Zunahme der Fitness von Organismen beschreibt. Zusammen mit Pearson entwickelte er u. a. die Grundlagen der Versuchsplanung (1935 erschien ''The Design of Experiments'') und der [[Varianzanalyse]]. Des Weiteren lässt sich die Mehrzahl der biometrischen Methoden auf Pearson und Fisher zurückführen auf deren Grundlage [[Jerzy Neyman]] und [[Egon Pearson]] in den 30er Jahren die allgemeine [[Testtheorie (Statistik)|Testtheorie]] entwickelten.<ref>Lothar Sachs: ''Statistische Auswertungsmethoden.'' 1968,1. Auflage, S. 436.</ref>

Herstellung von Orangensaft

Befragungen ohne Anwesenheit von Aufsichtspersonen, zu denen die Online-Befragungen gehören, führen bei manchen Probanden zu einer Reduktion der Reliabilität, da die Motivation und die Disziplin ohne Aufsicht niedriger ausfallen. Es ist zu vermuten, dass durch die Neuartigkeit des Instruments Bedienprobleme entstehen, welche die Reliabilität senken.

Bei der Beurteilung der Reliabilität von Online-Befragungen ist zu beachten, dass die WWW-Umgebung äußerst dynamisch ist und soziale Einstellungen sich hier schnell ändern. Eine Instabilität der Werte kann den Eindruck mangelnder Reliabilität der Messung entstehen lassen – in diesem Fall ist jedoch nicht das Instrument, sondern die Veränderung der Einstellung der Auslöser für die Abweichung. Wenn ein solcher Effekt vermutet wird, ist die Test-Retest-Methode zur Prüfung der Reliabilität ungeeignet. Der Einsatz der beiden anderen Methoden wird durch die Technik erleichtert, die eine einfache Aufteilung in Gruppen ermöglicht. Dabei ist sicherzustellen, dass Wiederholungsbesucher nicht mit unterschiedliche Messinstrumenten konfrontiert werden, bzw. in solchen Fällen nur die Erstergebnisse gewertet werden.

Quellen

C. Reinboth: Möglichkeiten und Grenzen von Online-Befragungen unter besonderer Berücksichtigung der Daten- und Stichprobenqualität, Diplomarbeit, Hochschule Harz, Wernigerode, 2005.

Batinic, B. (2003). Datenqualität bei internetbasierten Befragungen. In A. Theobald, M. Dreyer & T. Starsetzki (Hrsg.), Online-Marktforschung (S. 143-160). Wiesbaden: Gabler.

Theobald, A. (2000). Das World Wide Web als Befragungsinstrument. Wiesbaden: Gabler.

Pepels, W. (1997). Lexikon der Marktforschung. München: C.H. Beck.